Tecnología para 5G (Parte II – Redes, Virtualización y IoT)

Tecnologías 5G de gestión de redes y servicios

No todos los avances necesarios para la materialización de 5G son en el área de la interfaz de comunicación inalámbrica. También es necesario cambiar ciertos paradigmas y arquitecturas de las redes de conexión de forma tal que reflejen la multilateralidad de plataforma de servicios que representará 5G. Para ello es necesario un manejo de las conexiones más adecuado a los requerimientos de los servicios a prestar al mismo tiempo que, como fue mencionado anteriormente, la rentabilidad y el costo de prestar tales servicios no se incremente con respecto a las generaciones anteriores. Para ello ha sido necesario considerar en el desarrollo de 5G varias tecnologías emergentes de gestión de redes y servicios:

-

Redes definidas por software (SDN – Software Defined Networks) y Virtualización de funciones de red (Network Functions Virtualization – NFV). Estas tecnologías permiten un uso dinámico de los recursos de las redes de conexión y transporte, permitiendo la creación y destrucción de funciones de redes, proveedores de servicios, controladores y de manejo de paquetes en las redes. Gracias a la virtualización, es posible desligar la capa de orquestación u organización y configuración de las redes del hardware que es utilizado en la implementación, permitiendo una mayor interoperabilidad entre proveedores de software y el control dinámico de los parámetros de operación. De una forma u otra, la idea detrás de su uso para 5G es el de traer los beneficios y el potencial de servicio que es ofrecido hoy en día por las llamadas “plataformas de nube” (cloud), que utilizando centralización de procesamiento pueden servir a múltiples instancias y entidades simultáneamente, asignándoles dinámicamente recursos de sus vastos centros de cómputo. Adicionalmente, estas tecnologías permiten en teoría la reducción del costo de los equipos utilizados en las redes, puesto que posibilitan que funciones que anteriormente se ejecutaban en equipos especializados (SPU – Special Processing Units) se puedan ejecutar en equipos de uso general (GPU – General Processing Units) que generalmente tienen un costo menor. El contraargumento contra el uso de estas tecnologías ha sido la reducción del rendimiento y eficiencia del procesamiento requerido por funciones especializadas de la red que requieren una latencia y volumen de datos por tiempo específico para no ralentizar la operación en toda la cadena de comunicación. Hoy en día el rendimiento y fiabilidad de los equipos de uso general se ha visto incrementado grandemente y su costo se mantiene más bajo gracias a la economía de mercado de la producción en masa. Lo que ha recortado grandemente la diferencia de rendimiento con los equipos especializados. Y finalmente la arquitectura de la red central o core está siendo revisada por las organizaciones de estandarización, de forma tal que se puedan minimizar el número de funciones con requerimientos exigentes de latencia y volumen de datos para reducir las dependencias a equipos especializados y maximizar el uso de NFV en la red central.

-

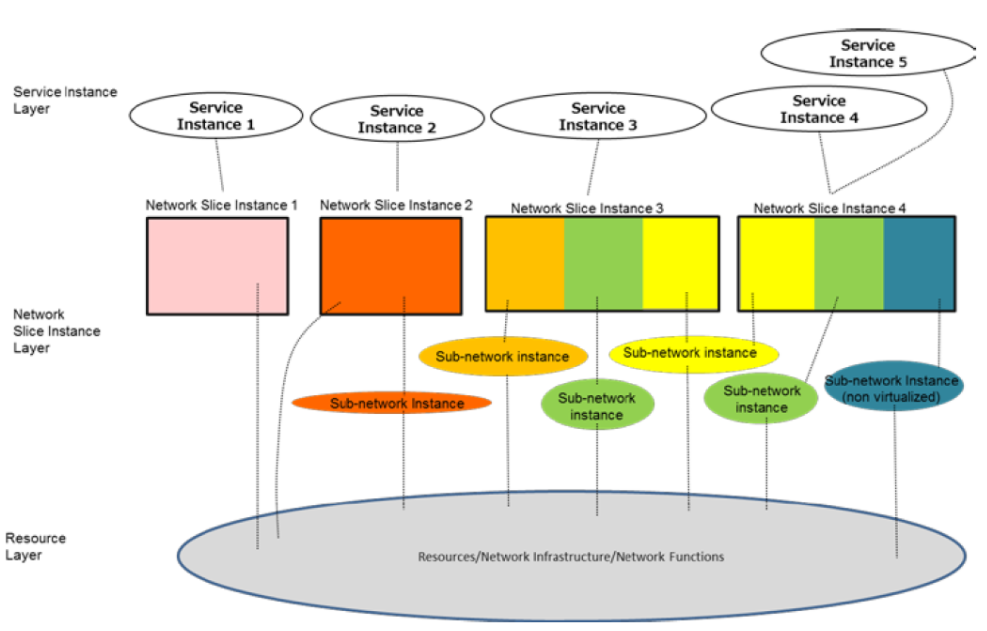

Partición de red (Network slicing).El uso de las tecnologías de NFV y SDN facilita crear “instancias” de la red que pretenden cubrir las conexiones de extremo a extremo con un alto grado de aislamiento entre los componentes, lo que en teoría permitiría una adecuación de los parámetros de operación de cada una de las “instancias” a uno o varios casos de uso o para ser más específicos a un conjunto de requerimientos para servicios. En cierta forma estas “instancias” podrían visualizarse como una rebanada de la red que cubre todas las capas y servicios de la red y que se multiplican de acuerdo a las necesidades y servicios a prestar en conjunción con la disponibilidad de recursos físicos de la red (procesamiento, conexiones, memoria, etc.). Adicionalmente, las particiones de red se esperan sean de naturaleza dinámica, lo que permitiría ajustar la cantidad de recursos utilizados para servir una partición (o “instancia”) en un determinado momento de acuerdo a la demanda, los contratos de calidad de servicio y el tipo de aplicaciones en servicio. A pesar de ser un concepto abstracto relativamente fácil de entender y de visualizar sus beneficios (rendimiento optimizado, reducción de consumo de energía, reducción de costos de equipo), en la práctica su implementación es controvertida, sobretodo en el tema de la estandarización. Las razones tienen que ver tanto con cuestiones técnicas como comerciales e incluso filosóficas, puesto que no existe total consenso en la definición de partición de red (slice).

Esquema descriptivo de las particiones de red (Slices) de acuerdo a NGMN. Fuente:NGMN alliance, Description of the Slicing concept. January 2016. https://www.ngmn.org/uploads/media/160113_Network_Slicing_v1_0.pdf

-

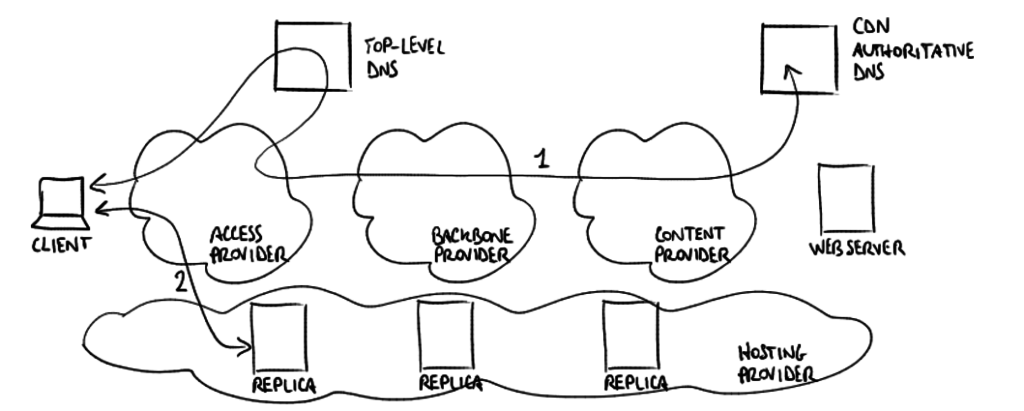

Caches y Redes de Distribución de Contenido (Content Delivery Network – CDN).La optimización de recursos de red para la distribución de contenido es algo que beneficia tanto a usuarios como a operadores, por tanto es una de las tecnologías con grandes posibilidades de verse implementadas. Los beneficios principales son la rapidez de servicio o de disponibilidad del contenido, el cual es almacenado en centros de distribución de la red en unidades de memoria especiales llamadas cache. Su éxito como concepto se basa en la premisa de que la gran mayoría del contenido consumido en las redes es prácticamente el mismo. Es decir, los usuarios tienden a ver los mismos videos, a leer las mismas noticias y escuchar las mismas canciones (lo que hoy en día llamamos tendencias de moda o “trending”). El principal problema de la implementación de las redes de distribución de contenido es el paradigma vigente actual de conexión que ha sido clave para el éxito de la internet basado en en IP y sus protocolos de transporte compatible. Con el paradigma actual, el contenido es más o menos transparente para los protocolos de ruteo y el usuario sabe exactamente dónde encontrar el contenido gracias a buscadores o índices de información (por ejemplo Google, Yahoo o Bing). En el concepto de CDN, los protocolos de transporte son orientados al contenido y por tanto no es necesario para un usuario conocer exactamente donde encontrar dicho contenido, pero la red se encarga de encontrarlo automáticamente si está disponible. Uno de los intentos de implementación de CDN es el paradigma de PubSub (Publicación y Suscripción) que rompe parcialmente con el modelo de conexión y ruteo utilizado por IP y el contenido es ofrecido por medio de publicaciones (independientes de donde el contenido está almacenado) y de suscripciones a el contenido solicitado (y que no necesariamente está aún disponible). Lo más cercano a este tipo de redes son los servicios prestados por operadores de cache (por ejemplo Akamai), los cuales gestionan algunas de las conexiones de los sitios web más populares del internet con los operadores móviles y proveedores de internet de diversas partes del mundo, proveyéndoles con copias de los sitios web en localizaciones cercanas a su conexión central (backbone) y facilitando la distribución de contenido por medio de caches.

Ejemplo de DNS-based CDN browsing. Fuente: Luca Ghio [CC BY-SA 4.0], via Wikimedia Commons

-

Exposición de las capacidades de la Red.Los servicios y “capacidades” de la red pueden ser publicados y expuestos a otras funciones internas o las llamadas terceras partes. A pesar que esto en cierta forma con la separación de capas del modelo ISO, permite que se establezcan optimizaciones entre dichas capas que mejoran e incrementan el rendimiento de toda la red de extremo a extremo. La exposición de estas capacidades serían grandemente aprovechadas por aplicaciones que utilizan la red 5G como una plataforma, y que por tanto, pueden hacer uso de dichas capacidades para prestar un servicio más completo o incluso para complementar los servicios prestados por dicha red. Este punto es algo controversial desde punto de vistas filosófico (la defensa de la independencia de las capas) y comercial (la generación de un valor o ganancias y su receptor). Por lo tanto, en una primera fase es probable que la exposición de capacidades estén íntimamente ligadas a temas de facturación y de regulación, y vigilancia de normas y preceptos de uso.

Facilitando el Internet de las cosas y la conectividad ubicua

El uso de IPv6 como protocolo de transporte y direccionamiento es una de las apuestas más seguras para el manejo del internet de las cosas. Además de la necesidad de comunicación con dispositivos con capacidades de procesamiento y memoria limitadas, lo que requiere de protocolos simples pero estandarizados que puedan operar a través de concentradores o agregadores mejor conocidos como IoT gateways o directamente conectados a Internet. La forma de conexión, bien sea inalámbrica o por cableado tiene también sus consideraciones a la hora del uso de innovaciones y prestación de servicios.

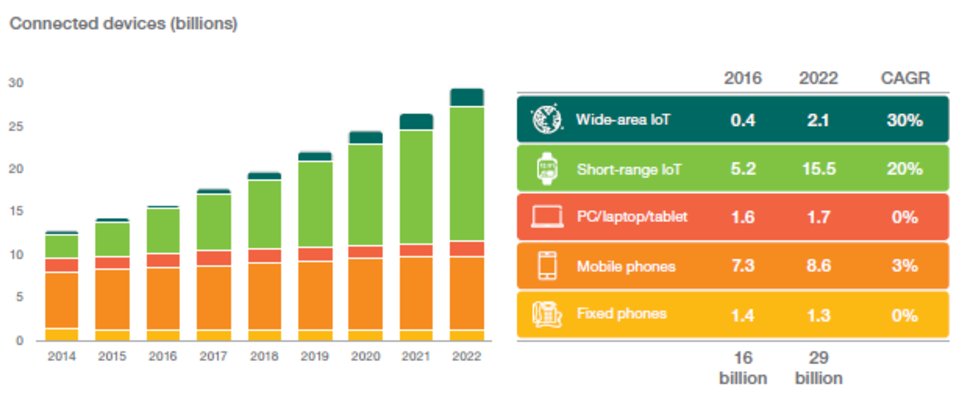

La llamada internet de las cosas (Internet of Things – IoT) ha sido uno de los temas más discutidos y etiquetado como el caso de uso más prometedor para las tecnologías de 5G al mismo tiempo que calificado como un reto complicado. El hecho de conectar cosas que básicamente operan por medio de algoritmos incansables, con limitaciones en el tipo de respuestas u observaciones que pueden proveer y con métricas e indicadores clave (KPIs) totalmente diferentes a las usadas por usuarios humanos, requiere de mecanismos y controles especiales que permitan una operación fluida de la red y sus servicios. Por ejemplo, un dispositivo que trata de acceder incesantemente a una red para la que no tiene una buena cobertura, continuará haciéndolo si su programación así se lo indica hasta que sus baterías se agoten, además podría darse la situación que esos intentos interfieran con los intentos de un usuario humano tratando de conectarse a la red para realizar una llamada de auxilio. A pesar de ser un ejemplo extremo, describe bien los horrores de un sistema sin consideraciones para el tráfico generado por entidades no-humanas. Las previsiones de conexión de estos dispositivos son enormes, llegando a los millardos de unidades conectadas en los próximos años. Además del manejo del tráfico, es importante considerar el manejo de su ciclo de vida, donde desde el momento que el dispositivo sale de la fábrica debe estar listo para su uso y conectividad automática, su mantenimiento y el fín de su vida útil. Imaginemos las complicaciones de tener que configurar passwords, nombres de estaciones de conexión, agregar tarjetas SIM y desbloquearlas, instalar actualizaciones de software, cambiar las baterías de los miles de dispositivos que podrían utilizarse en un edificio inteligente. Básicamente no es algo factible, por lo que todas esas funciones deben minimizarse o automatizarse totalmente y para ello varios sistemas especializados han sido diseñados o se encuentran bajo desarrollo y el rendimiento de las baterías incrementado por medio de ahorro de energía y mejoras en la tecnología utilizada.

(Fuente: Ericsson Mobility Report. June 2017. https://www.ericsson.com/assets/local/mobility-report/documents/2017/ericsson-mobility-report-june-2017.pdf)

En gran parte las expectativas de IoT están en aplicaciones desarrolladas por las llamadas terceras partes (Third parties). Estas son entidades generalmente comerciales que producen aplicaciones que se basan en el procesamiento de la información y en el control de los dispositivos de la internet de las cosas. Algunas de estas aplicaciones se ejecutan en un ambiente “vertical”, donde la aplicación tiene que ocuparse de todas las funciones de extremo a extremo para proveer el servicio deseado. Este modelo ha sido fuertemente cuestionado hoy en día debido a sus costos y su escalabilidad pobre. Por lo que el nuevo modelo se basa en servicios prestado sobre plataformas. Las plataformas se encargan de lidiar con muchos de los detalles de más bajo nivel de los servicios prestados por las aplicaciones que son comunes para cualquier tipo de aplicación, como por ejemplo la conectividad (por ejemplo provista por 5G) o la administración y seguridad de las comunicaciones. También es posible que las plataformas se presenten como una mercado de aplicaciones que permite a los usuarios acceder a varias opciones competidoras entre sí y elegir indistintamente la preferida sin necesidad de cambiar los equipos utilizados. Las plataformas pueden existir en varios niveles, e incluso concatenarse las unas con las otras para proveer un servicio final o incluso prestarse servicios entre ellas. Su uso y éxito se debe a sus bajos costos, escalabilidad y gran capacidad de adaptación con respecto a las soluciones verticales.

Otro de los conceptos más mencionados en el ámbito del internet de las cosas es conocido como Big Data (lo cual podría traducirse aproximadamente como Datos en cantidades Inmensas). Esta premisa sostiene que es posible inferir una gran cantidad de información por medio del procesamiento y correlación de los datos producidos por las entidades conectadas al internet de las cosas y al seguimiento y observación de información generada por los sistemas digitales. El uso de algoritmos de inteligencia artificial que permiten análisis profundos de información y de clasificación de información (clustering) han permitido el surgimiento de nuevas formas de negocio en varios ámbitos, algunos no exentos de controversia, especialmente con respecto a los límites de la privacidad. Donde muchas veces una compañía privada puede tener más información sobre una persona que su propio gobierno.

El uso de plataformas y de estándares abiertos para el procesamiento de la información requiere no solo que los formatos de datos utilizados sean compatibles estructural y sintácticamente (por ejemplo, la temperatura se manifiesta con un valor escalar numérico y no con caracteres de texto), sino que además requiere de compatibilidad semántica de forma tal que la información pueda ser interpretada de la misma forma en todos los puntos de procesamiento. Por ejemplo cuando se habla de temperatura, sea claro que es absoluta y no relativa con respecto al ambiente, o si se describe un color, digamos rojo, se hace en términos de un formato RGB, o CMYK, pero que es entendido por todas las partes el significado de los valores dados. A pesar de parecer un hecho trivial, la realidad es más complicada. Varias iniciativas han tratado de atajar este problema utilizando perspectivas diferentes (OCF, W3C, ISO, etc.), lo que ha desencadenado que existan varias alternativas no totalmente compatibles entre sí, y algunas incluso dirigidas a un contexto en particular.

Finalmente, mucho se ha hablado del uso del “machine intelligence” que son algoritmos de inteligencia artificial, para controlar la marea de datos y dispositivos conectados. Adicionalmente, su uso se está haciendo cada vez más presente en el manejo mismo de las redes, desde la optimización de los algoritmos de movilidad (por ejemplo para la predicción de la mejor conexión), la gestión de recursos, y la auto configuración y reparación de fallas. Por tanto la inclusión de estos algoritmos serán parte integral de nuestras vidas en un futuro muy cercano y algunas cosas que han sido identificadas además de las ya mencionadas (privacidad) para su aplicación segura, por ejemplo la capacidad de inspeccionar y auditar decisiones, la binarización de la información a procesar, los modelos en ambientes de limitado procesamiento y conectividad, entre otros.